これぞ10万トークン!Anthropicの最新LLM「Claude2」を早速試す!

持つべきものはアメリカ在住の友達!

OpenAIを抜けた人たちが作ったAnthropic社が、ChatGPTに対抗しうる強力なAIをリリースした

Anthropicの最新LLMであるClaude2は、ベンチマークでGPT-3以上GPT-4未満と言われている。しかしその特徴は、10万トークンという長大なトークンを扱えると主張されていることにある。

ちなみに大規模言語モデルでトークン数を沢山扱えるという主張には注意すべきという意見もあるのでご注意。

I'm calling the Myth of Context Length:

— Jim Fan (@DrJimFan) July 10, 2023

Don't get too excited by claims of 1M or even 1B context tokens. You know what, LSTMs already achieve infinite context length 25 yrs ago!

What truly matters is how well the model actually uses the context. It's easy to make seemingly wild… pic.twitter.com/FKqjs3xb6O

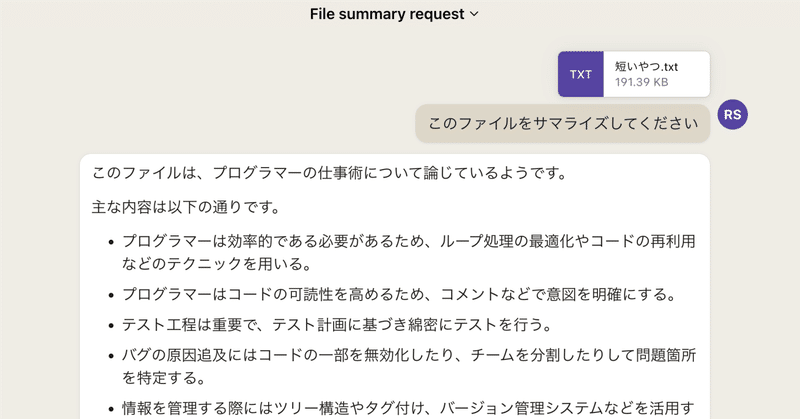

試しに、拙書「最速の仕事術はプログラマーが知っている」の原稿を読ませてみたい。日本語で10万字。

ところがClaude-2のベータ版はアメリカとイギリスでしか使えない!OMG!

しかし清水総研ベイエリア支部ことドリ山田金太郎はアメリカ在住。

ドリ山田金太郎によって試すことかできた!

ただし、12万字の原稿だと「20%オーバーしてる」と怒られた。すげえ。本当に10万トークンさばくらしい。

そこで短いファイルを作ってサマライズさせてみた。

最初の質問は結構時間がかかった。本当に10万トークン、つまり本一冊分くらいの情報を読んでいるのだろうか。

さりげなく使っているが、日本語でもバッチリ応対してくれる。

GPT-4が単一のモデルではなく複数のモデルの組み合わせで構成されていると言われている。ちなみにこの記事は本当にお金を払って読む価値がある。

おそらくClaude-2もそうではないかと思う。

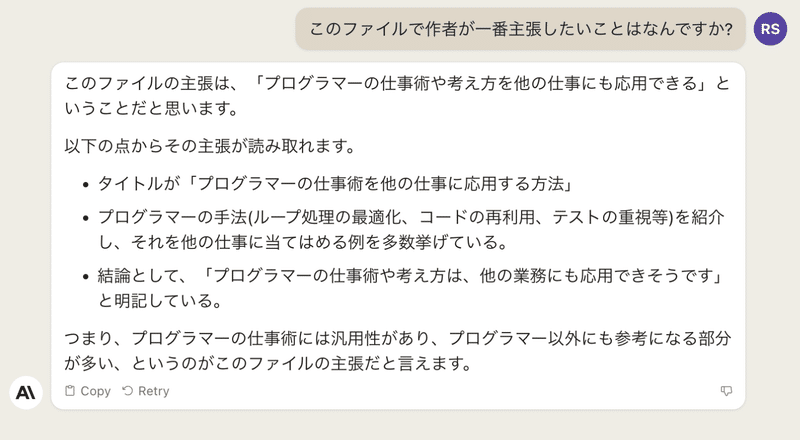

サマった後で「作者の気持ちを答えよ」的なことを聞いてみた。

作図機能はないはずだが、「図にしろ」みたいな無茶苦茶な話も一応答えてくれる。

さらに内容を発展させろというかなり高度な問題にも答えられる。

プログラムも書ける

このコードはバグってる上に不完全だ。moon_xしか更新しない上に、moon_xがローカル変数になっている。

その後何度やり取りしても正しいプログラムは書いてくれなかった。

プログラム記述能力では今のところChatGPTのCode Interpreterに軍配が上がる。

ただ、10万トークンを本当に捌いてるとすると、ちゃんと理解できるのであれば長いプログラムはClaude2の方が得意なはずだ。

しかし、「10万トークン」というのは「ものはいいよう」という話かもしれない。GPT-4と同様にClaude-2の内部構造は明かされていない。

内部にChatPDFと同等のものを用意して、その制限が(単に容量的な制約として)10万トークンと主張しているかもしれないからだ。

どちらにせよ、これまで最終的な性能に関してはGPT-4一強だったが、強力なライバルが現れたのは喜ばしいことだ。

ありがとうドリ山田金太郎!